セキュアでプライベートな AI

信頼性の高いインテリジェンスを採用

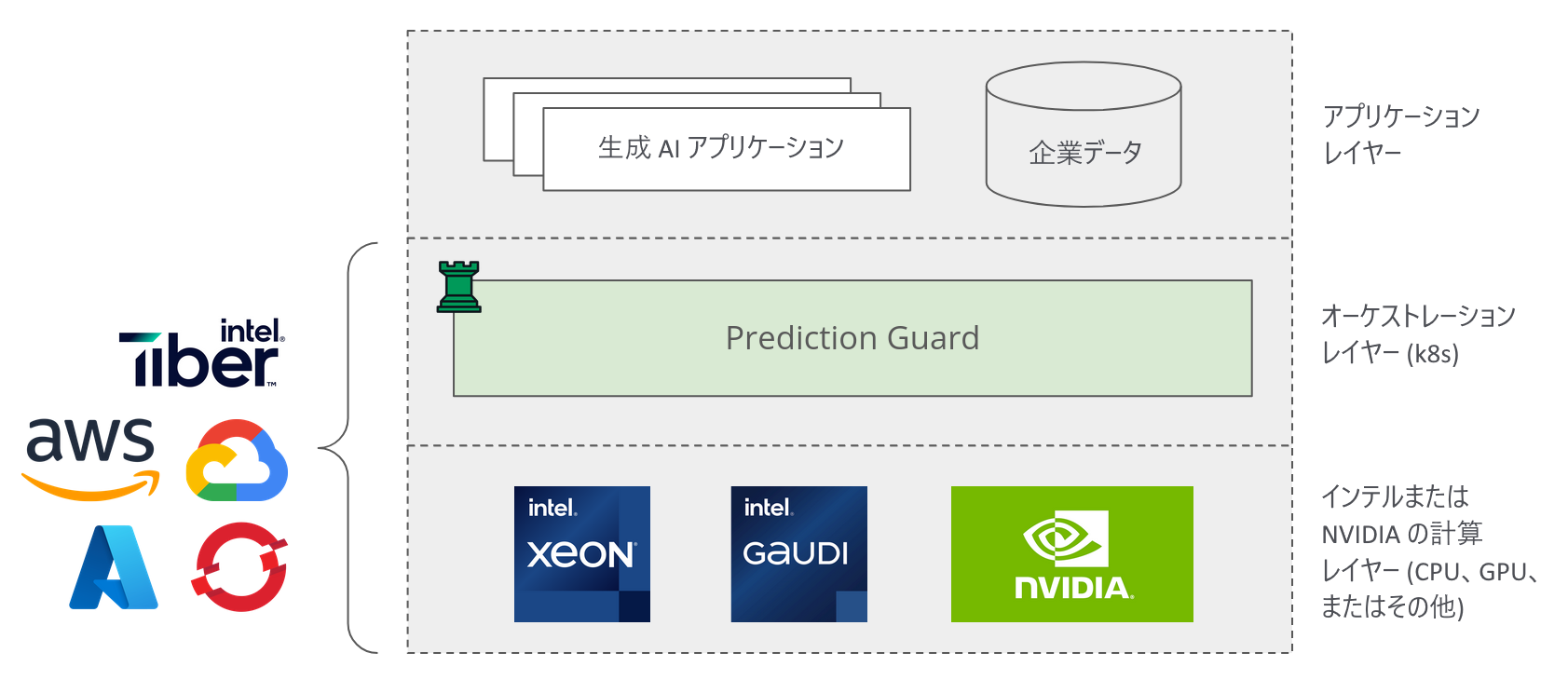

モデルの自己ホスティング

Llama 3.1、Mistral、Neural Chat、DeepSeek など、最も人気のあるモデルを任意のインフラストラクチャでプライベートに実行できます。お客様の環境、ユースケース (専門分野、トレーニングなど)、業界にマッチするモデルをデプロイ。管理パネルから簡単に選択、または独自のカスタム モデルをアップロードできます。

セキュリティのモニタリング

API キー、モデル、時間、イベント種別ごとに、きめ細かなレベルですべての AI モデルの入力および出力を継続的に監視します。OpenTelemetry イベントを通して、任意のログ管理およびアラート システムに追加。プロンプト インジェクション、個人情報 (PII) の漏洩、ハルシネーション (誤情報)、有害な出力などの脅威を未然に防ぎ、モデルやユーザー入力の動作を可視化します。

AI セキュリティの監査

API キーのプロビジョニングからモデル バージョンの更新まで、AI システムのデプロイメントに対して実行されたすべての変更を追跡できます。変更履歴をエクスポートおよび分析することで、AI の現状を現在かつ過去のどの時点でも理解できるようにし、時間の経過とともに AI システムを完全に監査できるようになります。

開発者向けの使いやすさ

Prediction Guard のデプロイメント環境で公開されている API は、OpenAI と互換性があります。これは、データが OpenAI に送信されることを意味するものではなく、OpenAI の API と仕様レベルの互換性があることを示します。つまり、OpenAI 上に構築されたアプリケーションは、システムのベースとなる URL を交換するだけで簡単に Prediction Guard 上で実行できます。開発者は、エコシステム内で利用可能なツール (LangChain、LlamaIndex、Vercel の AI SDK など) をすべて利用できます。

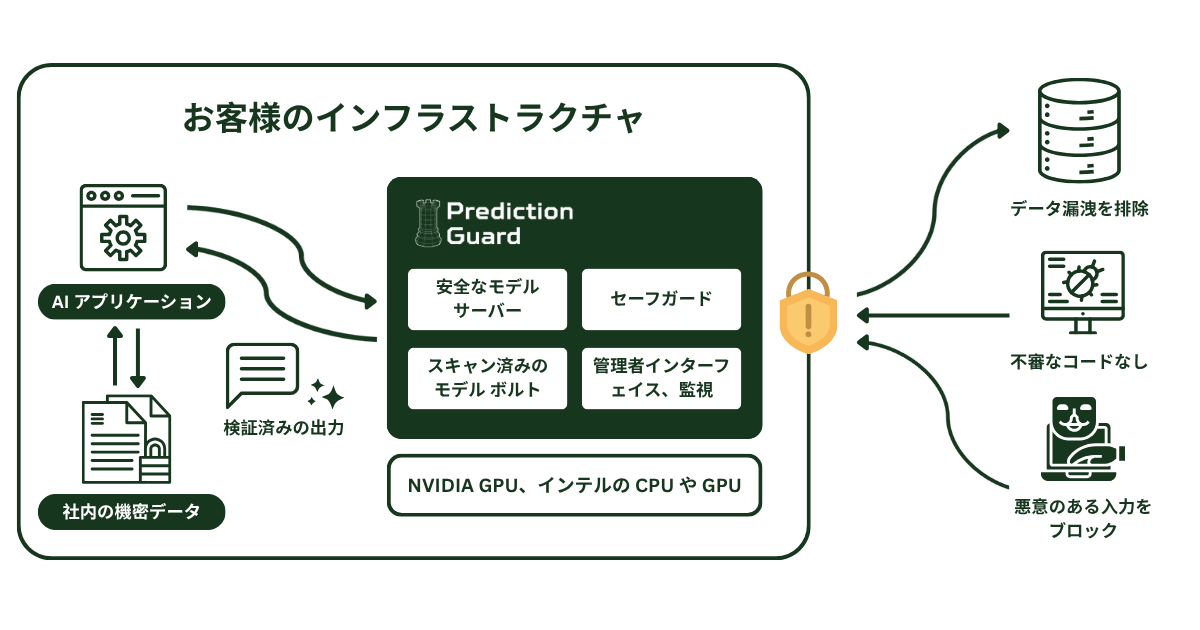

セキュリティのベストプラクティスに準拠

機密性の高いデータを活用した特化型 AI ソリューションの構築を実現

Prediction Guard は、NIST (英語) と OWASP (英語) が推奨する AI セキュリティ/プライバシーのベストプラクティスを実装し、コンプライアンスとセキュリティの維持を確保します。これにより、ネットワーク外へデータを漏洩することなく、機密性の高いシナリオでも AI の価値を引き出すことができます。