AI をアプリケーションへ統合しようと試みる企業は多いもの、プロトタイプから本番環境への移行は依然として大きな課題です。機械学習モデルを効率的に管理しながら、セキュリティとガバナンスを確保することが求められています。JFrog の NVIDIA NIM との統合は、エンタープライズレベルの DevSecOps の手法を AI 開発に適用することで、こうした課題の解決を支援します。本ソリューションの詳細に入る前に、まずは解決すべき主要な MLOps の課題を整理してみましょう。

技術的な課題 ~ MLOps のギャップを埋めるには

従来のソフトウェア開発とは異なり、機械学習モデルのパイプラインには特有の複雑さがあります。

- バージョン管理や保存のための、専用のアーティファクト管理

- モデルと実行環境の間での正確な依存関係の管理

- 効率的なデプロイを実現するための GPU リソースの最適な割り当て

- AI 固有の脆弱性に対応するための強化されたセキュリティ対策

これらの課題を解決するには、エンタープライズレベルの DevSecOps プラクティスと、AI に特化した最適化を組み合わせた専用のソリューションが必要です。

NVIDIA NIM の登場

NIM は、エンタープライズ向けの AI デプロイメントに特化したコンテナー化されたマイクロサービスを提供することで、先述の MLOps の課題に直接対応します。主な特長は以下のとおりです。

- NVIDIA ハードウェア上での事前最適化されたモデル実行

- 最高のパフォーマンスを引き出すための自動ハードウェア構成検出

- 複数の LLM ランタイムに対応

- OpenAI API 仕様との互換性

NIM が初めてデプロイされる際には、ローカルのハードウェア構成とモデル レジストリにある最適化済みのモデルを確認し、そのハードウェア環境に最も適したモデル バージョンを自動的に選択します。

こうした技術的な最適化により、AI デプロイメントにおける実行面の課題は解決されますが、企業全体での活用にはさらに多くの機能が求められます。

企業が AI 活用を部門や環境をまたいで拡大していく中で、モデルの実行だけではなく、ガバナンス、セキュリティ、配布といった新たな課題に直面します。

エンタープライズには、これらのマイクロサービスをライフサイクル全体にわたって統合的に管理・保護・配布・制御できる包括的なプラットフォームが必要です。ここで、NVIDIA の技術革新とエンタープライズレベルの DevSecOps を統合することで、JFrog プラットフォームが大きな価値を発揮します。

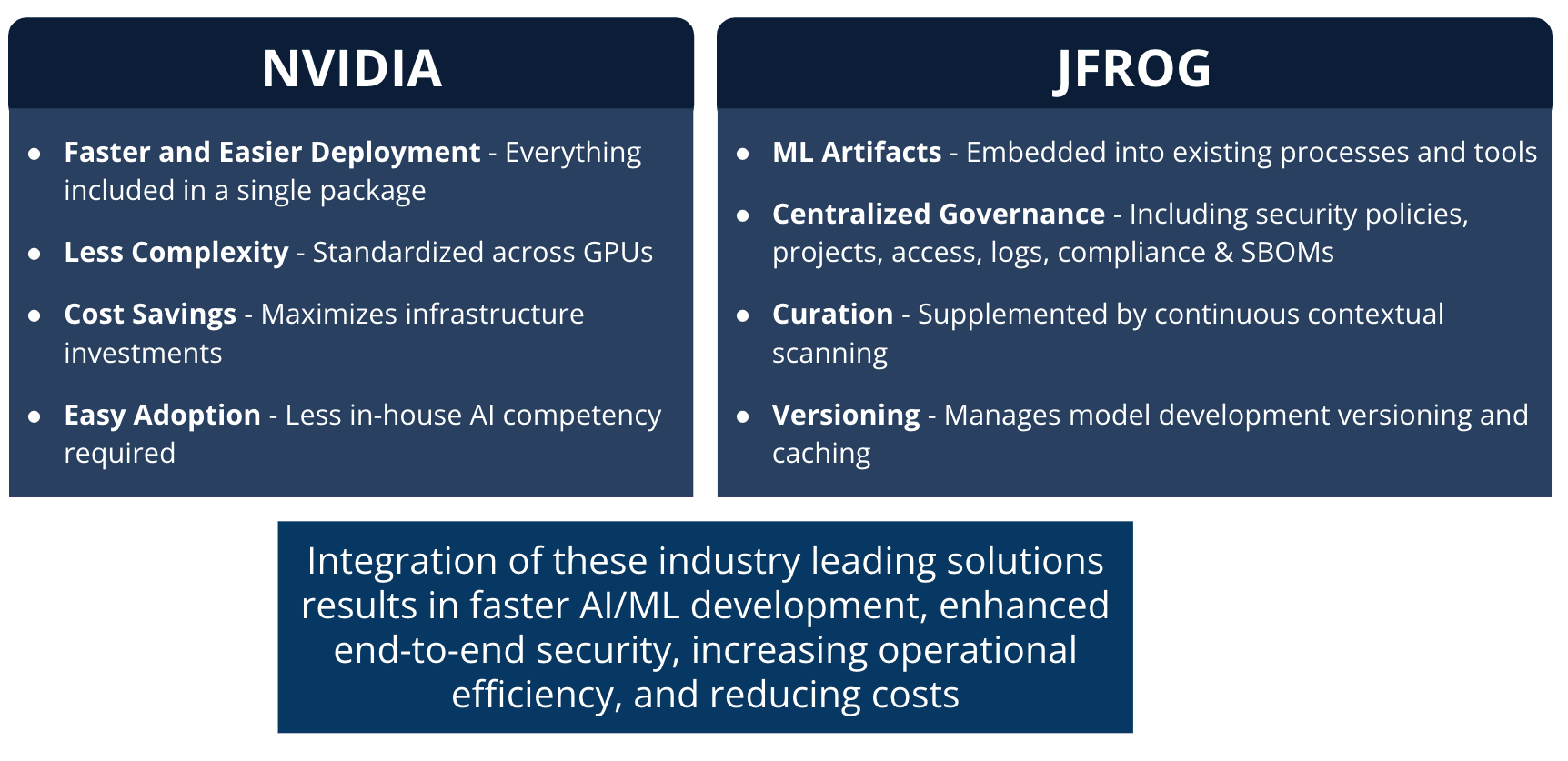

JFrog と NVIDIA NIM を統合する理由

AI ガバナンスの一元化

- JFrog の Curation や Xray ポリシーにより、NIM を細かく制御

- 企業の基準や規制に準拠した運用を実現

- 安全かつ迅速に NIM を全社に展開可能

セキュリティの強化

- NIM コンテナー、モデル、依存関係を継続的にスキャン

- 脆弱性のある NIM をポリシーベースでブロック

- 機械学習およびソフトウェア スタック全体への影響範囲を把握

スムーズな配布

- NGC やインターネットを介さずに、Artifactory から直接 NIM にアクセス可能

- 一元配布により帯域幅を節約

- 高セキュリティ環境でのエアギャップ展開にも対応

エンタープライズ向けの統制機能

- AI とソフトウェア資産を一元管理する「信頼できる単一の情報源」

- 完全な監査ログとバージョン管理機能

- ポリシーに基づくロールベースのアクセス制御

- DevSecOps とのシームレスな統合

NVIDIA NIM により、最適化されたランタイムで AI モデルをコンテナー化された推論マイクロサービスとして実行できるシンプルなソリューションが実現します。そして JFrog プラットフォームは、それにエンタープライズレベルのセキュリティ、ガバナンス、配布機能を加えることで、開発スピードを加速しつつ、コンプライアンスを確保する包括的な MLOps ソリューションを提供します。

この統合の戦略的なメリットをご理解いただけたところで、次は実際に自社の環境へ導入する方法を見ていきましょう。

実装ガイド

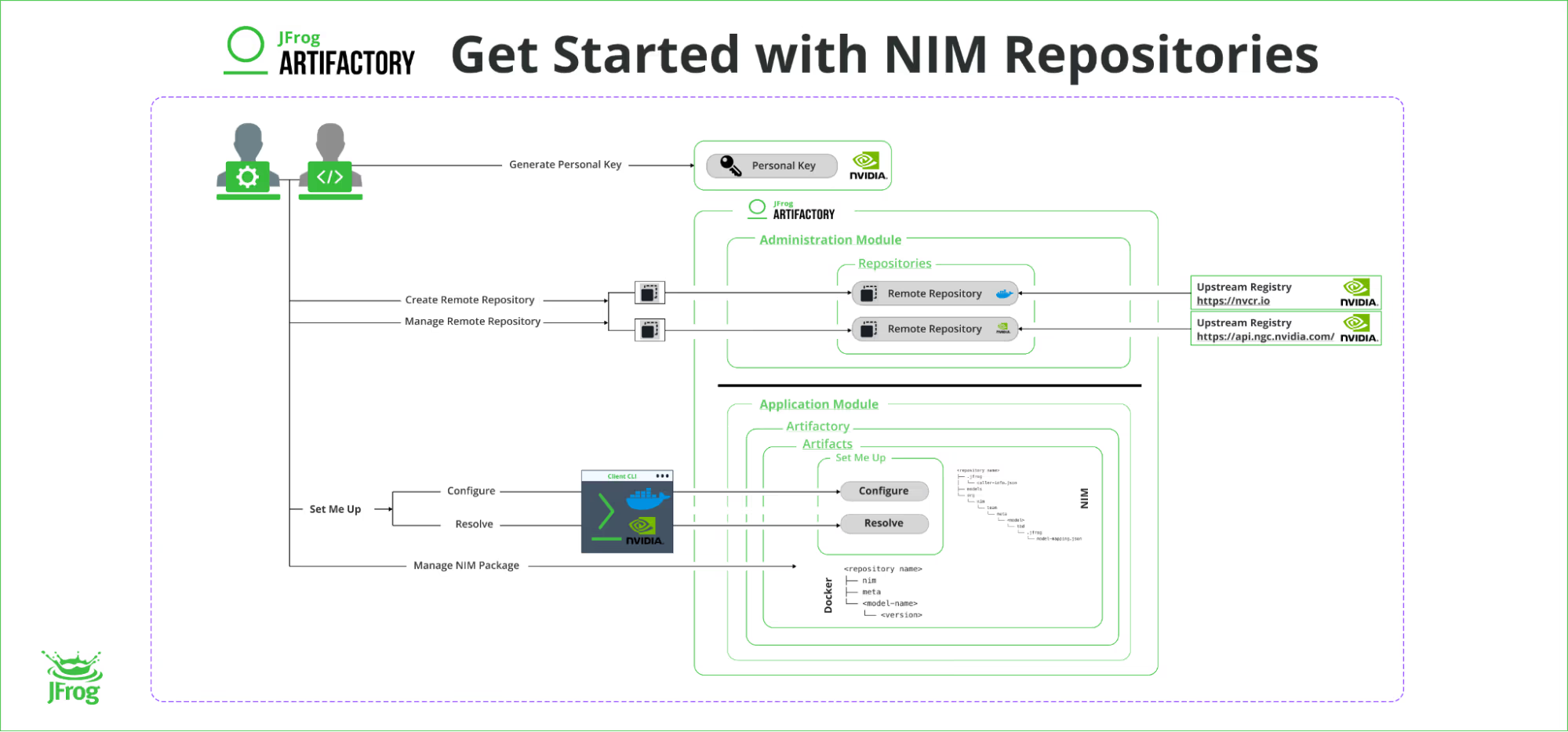

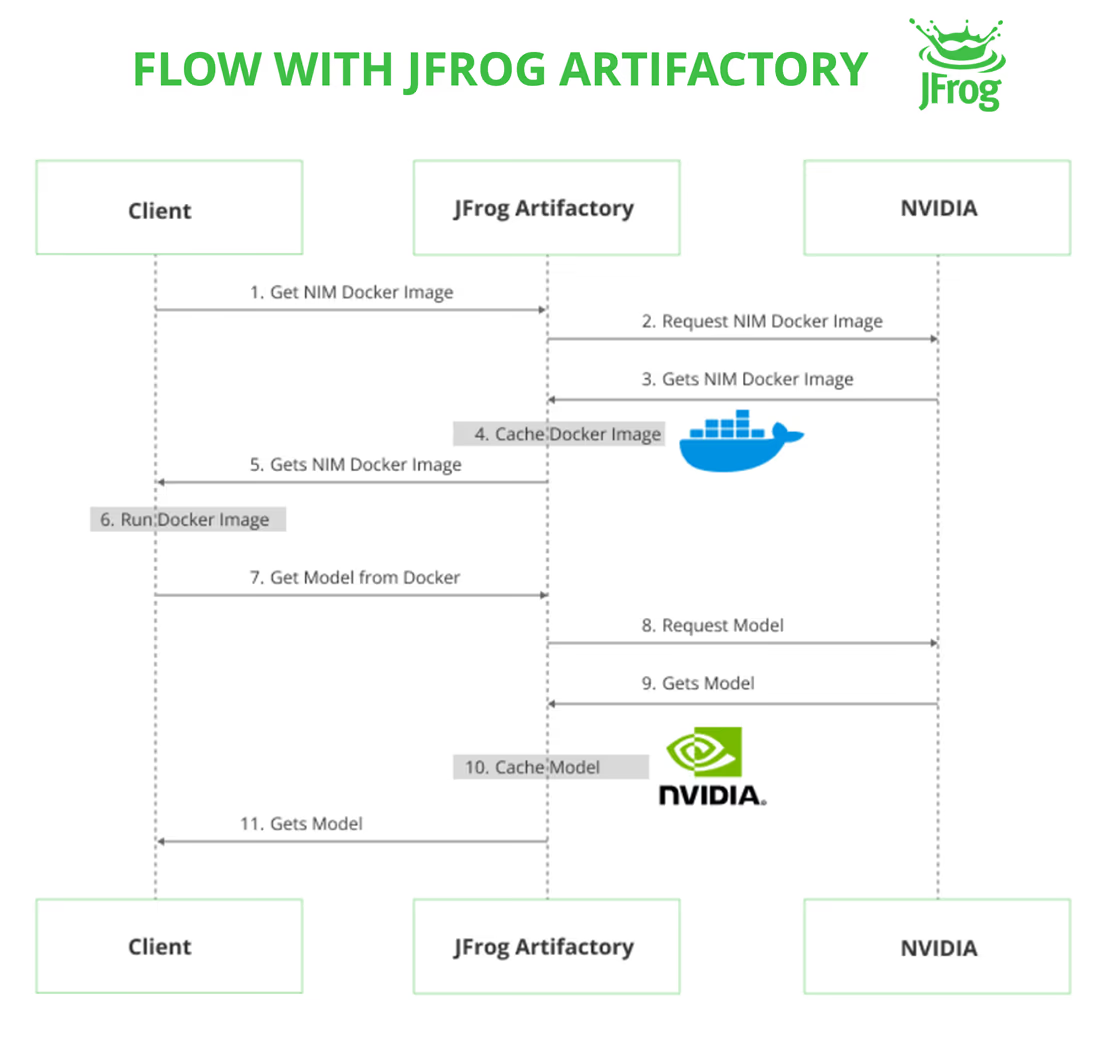

JFrog プラットフォームは、NVIDIA NGC に対するセキュアなプロキシとして機能し、NIM のイメージやモデルを既存のアーティファクト管理ワークフローの中で一元管理できるようになります。以下はそのセットアップ手順です。

1. NGC パーソナル キーを生成

NVIDIA NGC のアカウントから、パーソナルアクセストークンを作成します。

2. Artifactory にリモートリポジトリを設定

a. Docker リポジトリの設定

- リモート URL:

https://nvcr.io - ユーザー名:

$oauthtoken - パスワード (アクセストークン): 手順 (1) で生成した NGC パーソナル キー

b. NIM モデル用のリポジトリの設定

パスワード (アクセストークン): 手順 (1) で生成した NGC パーソナル キー

リモート URL: https://api.ngc.nvidia.com/

ユーザー名: 空欄のまま

3. ホスト マシンの設定

a. JFrog プラットフォームの「Application」タブをクリックし、「Artifactory」内の「Artifacts」を選択

b. 作成した NIM リポジトリを見つけ、「Set Me Up」をクリック

c. 表示される手順に従って、必要な環境変数を設定

d. ホスト マシンで以下のコマンドを実行し、Artifactory に対して Docker レジストリとして認証

docker login <domain>※ <domain> は例:awesome.jfrog.io のような Artifactory のドメインです。

e. NIM コンテナーを取得・実行するために、Docker コマンドを実行

ここまでで、NVIDIA NIM を JFrog 環境に統合するための基本設定は完了です。以下に、実際の設定画面のイメージもご紹介します。

1. はじめに

2. ワークフローの構築

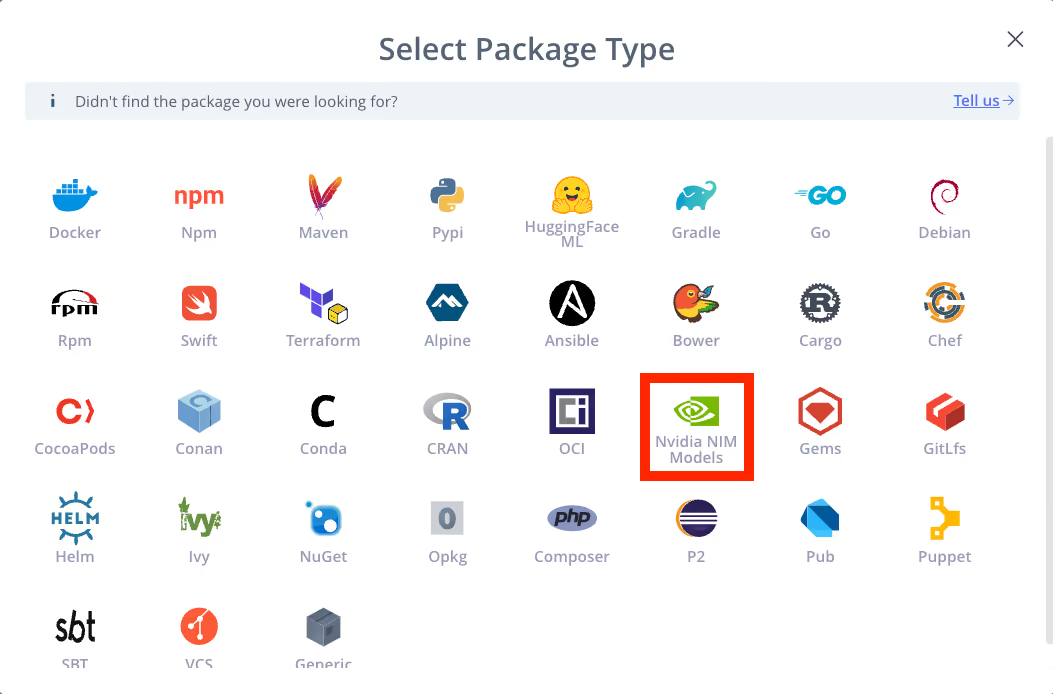

3. パッケージの選択

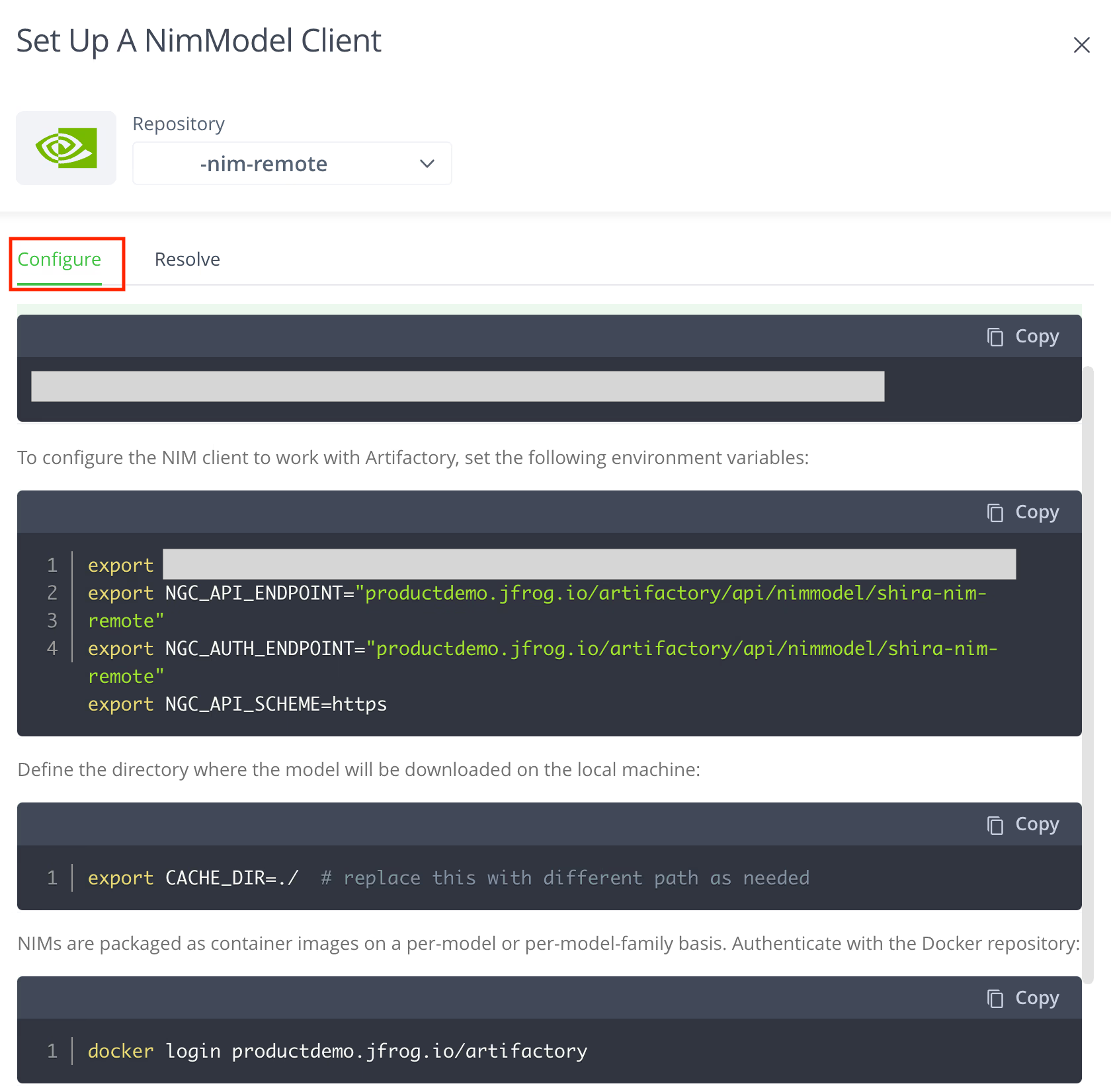

4. NIM モデル クライアントの構成

セットアップ

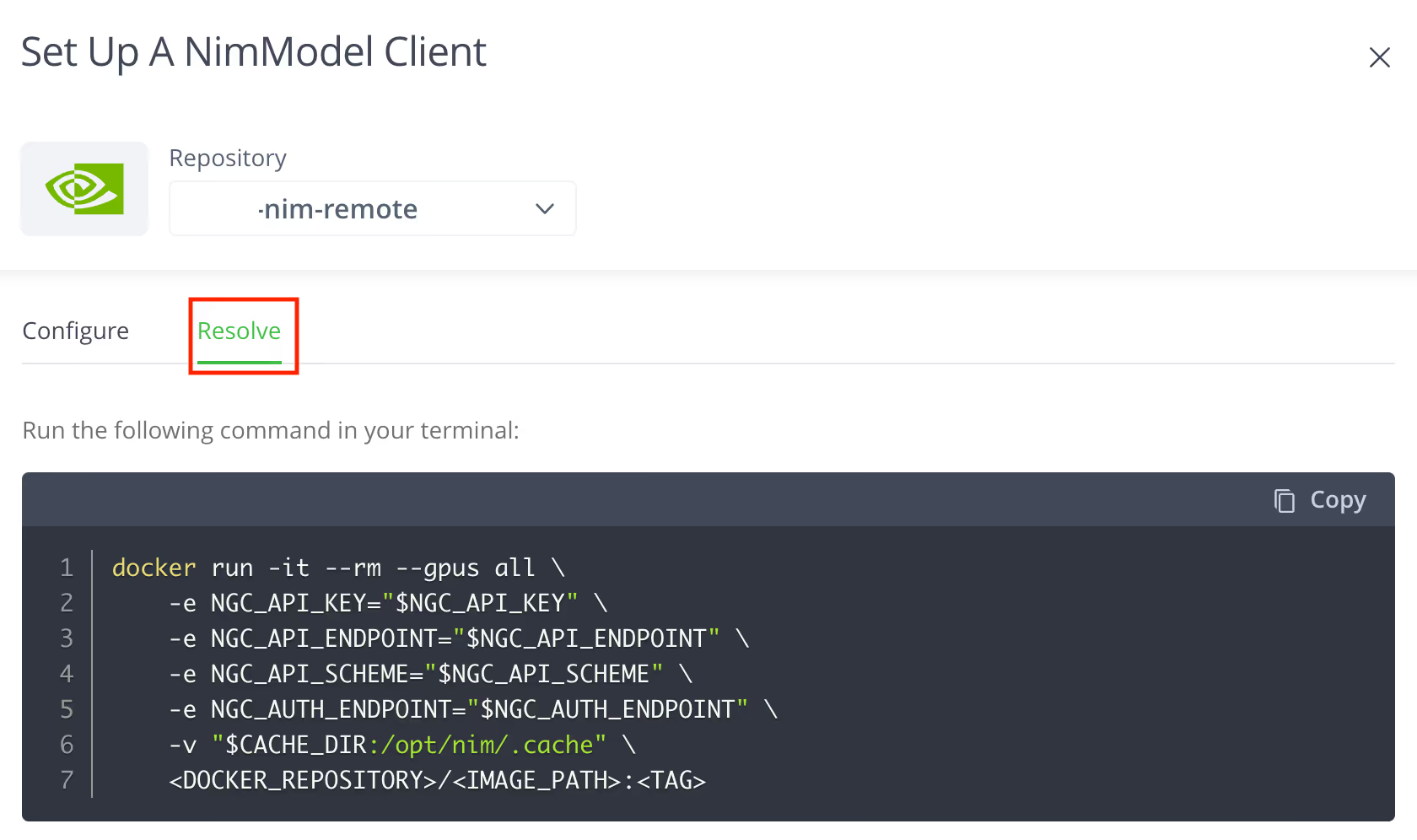

5. NIM モデル クライアントの解決

重要なポイント

JFrog と NVIDIA を統合することで、組織は AI モデルの管理を既存のソフトウェア開発のベストプラクティスに組み込むことができ、安全なストレージ、厳格な脆弱性スキャン、そしてハイブリッドおよびマルチクラウド環境での効率的なデプロイを実現できます。

この強力な組み合わせにより、セキュリティ、コンプライアンス、スケーラビリティを維持しながら、AI 主導のイノベーションを加速できます。AI の導入が進む中、JFrog の堅牢な DevSecOps プラットフォームと NVIDIA の最先端推論マイクロサービスを活用することで、企業はますます AI 主導の世界で競争優位を保つことができます。

JFrog Platform に関するご質問は、JFrog 日本正規代理店のエクセルソフトまでお問い合わせください。

記事参照: Accelerating Enterprise AI Development: A Guide to the JFrog-NVIDIA NIM Integration

世界の人気ソフトウェアを提供するエクセルソフトのメールニュース登録はこちらから。