この記事は、インテル® コミュニティーのブログに公開されている「Making HPC More Sustainable and Environmentally Friendly」の日本語参考訳です。原文は更新される可能性があります。原文と翻訳文の内容が異なる場合は原文を優先してください。

インテル グローバル・マーケティングのプロダクト・サステナビリティー・ストラテジストである Ralph Biesemeyer の代理として投稿しています。

インテルに在籍していた数年間、インテル® Select ソリューションの開発が私の職務の中心でした。私たちの最大の目標は、作成したソリューションでお客様を成功に導くことなので、この仕事はやりがいがあり、わくわくさせるものです。同時に、インテルには、HPC やデータセンターでのエネルギー消費量を削減するために、コンポーネントを磨き続ける責任があります。システムがより強力になればなるほど、一般的には、より多くのエネルギーを消費し、効率的に管理しなければならない熱を発生させます。このブログでは、この課題に対するクリエイティブなアプローチと、インテルのソリューションをより環境に優しいものにするために行っていることを紹介したいと思います。

冷却の効率化

プロセッサーに搭載される演算密度やコア数、アクセラレーター・カードなどのコンポーネントが効率的に動作するために、大きな電力を必要とする変曲点に直面しています。従来は、プロセッサーに搭載されたファンやヒートシンクによる空冷で、許容動作温度内を維持することができました。しかし、現在では、さらに大きな課題となっています。最新のプロセッサーは、より多くの熱を発生します。そのため、空冷式の空調設備が必要となっています。そこで、大規模データセンターの空調設備が整った部屋では、液冷方式が採用されています。

現在、この業界では液冷に対して水冷式冷却方式、チップ直下再循環方式、液浸方式などのいくつかのアプローチが取り入れられています。水冷式冷却方式は最も簡単で、ラジエーターと同じように動作します。サーバーには、水を含んだヒートシンクが取り付けられ、サーバーシャーシ内のラジエーターのようなデバイスにパイプが接続されています。チップ直下再循環方式は、ラックレベルで展開される水冷式冷却のようなものです。CPU やアクセラレーターの上に置かれたジャケットの中に水を送り込みます。水はプロセッサーの熱を集め、ジャケットを出てラックを出て、冷却され再循環されます。このような循環型のシステムでは、同じ水を繰り返し使用することになります。さらに、設備ファンやエアフローのみのヒートシンク方式で空気を循環させるよりも、はるかに冷却効果が高いのです。

液浸冷却は、仕組みが異なります。その名が示すように、システムは液体に浸されます。簡単に言えば、冷却液の入った桶の中にラックを置くということです。しかし、事前に各サーバーにちょっとした改造が必要です。オペレーティング・システムと BIOS の調整で、不要なファンを作動させないようにする必要があります。一部の OEM は、熱管理がタンクによって行われるため、ファンを排除できる液浸用サーバーを設計し、サーバーの設計を簡素化しています。

液浸槽の放熱方法には、2 つのアプローチがあります。「単相式」システムでは、クーラントは液状で槽内に残ります。加熱された液体は冷たい液体より少し密度が低いので、自然にタンクの上部に上がってきます。そこから、ポンプで最も温かい液体をすくい取ります。冷却された液体は、タンクの底に押し戻されます。

「二相式」液浸冷却は、仕組みが異なります。プロセスで使用されるエンジニアード・フルードは、冷えた状態では液体のままですが、サーバー部品で加熱されると気体になり、その気体は密閉タンクの上部に上昇します。そして、その気体は冷やされると再び液体となり、タンクに戻されます。このように、工学的な流体の有効性と環境への配慮を両立させることが課題となっています。

効率的な液浸冷却により、プロセッサーはオーバーヒートすることなく、より高いクロック速度で動作することができます。したがって、利用可能な電力を熱除去に費やすのではなく、実際の作業負荷に割り当てることができるため、システム性能を向上させることが可能です。さらに、液冷はファンよりもずっと静かであるというメリットもあります。

データセンターの効率は、PUE (Power Usage Effectiveness) によって測定されます。PUE は、データセンターのエネルギー効率を決定する簡単な計算です。目標は、PUE をできるだけ 1.00 に近づけることです。これは、システムが完全に最適化されていることを示します。液浸冷却の場合、データセンターの PUE の数値は 1.03 から 1.05 の間に収まっていることが確認されています。これは素晴らしい結果であり、私たちはさらに良い結果を出すために努力を続けていきます。

私たちは、副作用を伴わずに熱効率を向上させる可能性のある新しい工学的流体の将来の可能性に期待を寄せています。Green Revolution Cooling (GRC) と Submer は、液浸冷却の方法を開発する液浸技術のリーディング・ベンダーです。先進的な液体冷却技術は、現在、さまざまな段階の概念実証と生産展開が行われています。この手法により、冷却にかかる電気代を 90%、二酸化炭素排出量を 40% 削減できると見込んでいます。インテルの Submer 社とのパイロット契約については、こちらで詳細をご覧いただけます。

インテルはまた、オレゴン州にある 20 万平方フィートの研究所に 7 億ドル以上を投資する計画も発表しました。このチームは、暖房、冷却、水の使用に関する機能に焦点を当てる予定です。また、初のオープンな知的財産 (オープン IP) である液浸式冷却ソリューションとリファレンス・デザインを発表しました。

再生可能エネルギーの創出と活用

HPC システムやデータセンターが必要とするエネルギーを回避する簡単な方法はありません。しかし、「環境にやさしい」電力供給を実現するために、私たちができることはたくさんあります。トップレベルの目標は、化石燃料ベースのエネルギー源を削減または排除することです。インテルは、この共通の目標に向けて、お客様が参加できるクリエイティブな方法をいくつか考えています。

データセンターの設計者の中には、持続可能なエネルギーを最大限に活用するために、独創的なアプローチをとっている人もいます。インテルの顧客である atNorth 社は,オンプレミスの HPC インフラストラクチャーではなく,クラウドで高度なワークロードを実行できる HPC as a Service (HPCaaS) インスタンスをホストしています。atNorth 社のデータセンターはアイスランドにあるため、現地の平均気温が 5 ℃と低く、冷房の恩恵を受けることができるのです。さらに、アイスランドは水力や地熱のエネルギー源が豊富なことでも知られており、atNorth は現地の安価な電力を最大限に活用しています。

また、ある企業のデータセンターでは、液浸冷却システムを使って熱を回収し、別の目的に再利用しています。同社も atNorth 社と同様、データセンターを寒冷な地域に設置し、自然による冷却の手助けを得ています。しかし、同社は再生可能エネルギーという考え方をさらに進めています。データセンターの熱は、敷地内の温室に送られ、食料の栽培に役立てられているのです。また、ストックホルムのデータセンターでは、「廃熱」を利用した画期的なアイデアが実施されています。余分な熱はアパートの暖房に利用されています。

米国国立再生可能エネルギー研究所 (NREL) の HPC システム「Peregrine」も液体冷却を採用し、エネルギー効率を高めています。NREL はヒューレット・パッカード (HP) と協力してエネルギー効率の高いスーパーコンピューターを構築し、その温水でエネルギーシステム統合施設 (ESIF) の建物を暖房しています。

持続可能な電力を貯蔵するためのもう一つのユニークなアプローチは、データレイクだけでなく、実際の湖を使った揚水発電と呼ばれるプロセスです。太陽光発電などの再生可能エネルギーが余った場合、そのエネルギーを使って低い湖から高い位置にある湖に水を汲み上げます。そして、再生可能エネルギーが必要なときに、タービンを通して、高い湖から汲み上げた水を発電し、標高の低い別の湖へ下るという仕組みです。

データセンターと電力会社が、自然エネルギーや不要な熱エネルギーをいかに創造的に利用し、人々や環境に貢献できるかを示してくれています。

サステナビリティーに対する業界のコミットメント

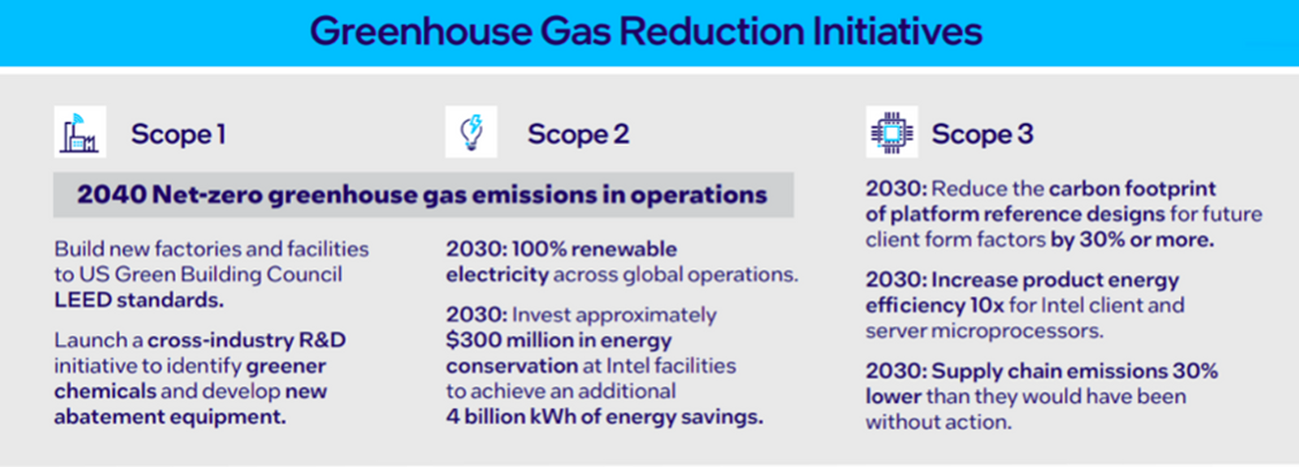

インテルはサステナビリティーに対して重要なコミットメントをしており、それを誇りに思います。私たちがとっているアプローチのいくつかに触れていきます。

まず、私たちの施設や工場では、より多くの再生可能な電力を使用する必要があります。米国と欧州の最新施設で、私たちがどのようにそれを行っているか、ご覧ください。インテルは現在、全世界で電力の 82% を再生可能エネルギー源から購入しています。工場、データセンター、施設で 100% 再生可能な電力を使用するという目標に近づいています。

次に、私たちは製品のエネルギー効率を高める努力を継続する必要があります。2030年までには、世界のエネルギーの 3~7% がデータセンターで消費されると推定されており、この数字は、テクノロジーがより少ない電力でより強力に機能しない限り、増え続けることになります。そのため、私たちは 1 ワットのエネルギーからより高いパフォーマンスを引き出し、データの移動に必要な「エネルギー税」を削減する方法を考えなければなりません。

3 つ目は、OEM パートナーと協力して、サーバーをより再生可能なものにするための取り組みを続けていることです。どんな電子機器も永遠に使えるわけではありませんが、私たちの製品をより長く使っていただければ、廃棄される古い部品の数を減らすことができます。

インテルは、主要なデータセンター・パートナーとともに、Open Compute Project (OCP) に貢献しています。OCP は、モジュール設計の推進、カーボン・フットプリントの測定基準の確立などに重点を置いています。最新の進歩は、Blue Glacier プロジェクトで規定されており、OCP を通じてモジュール設計の Revision 仕様を発表しました。また、インテル® oneAPI ツールキットを提供し、開発者が多くの HPC、AI、その他のワークロードを実行するために必要な電力を削減できるよう支援します。

インテルがプラットフォーム・レベルで二酸化炭素排出量を削減するもう 1 つの方法は、モジュール式または「チップレット」コンポーネント設計です。チップレット・アプローチは、プロセッサーとアクセラレーター・モジュールを個別に修理またはアップグレードして、プラットフォームの耐用年数を延ばすことができることを意味します。また、チップレット・コンポーネントは、カスタムのワークロードに合わせて構築することができ、より小さな物理パッケージで電力消費を最適化することで、より少ない炭素消費量を実現します。

インテルとオープンソースのテクノロジーは、HPC の電力要件を削減するための方法をさらにいくつか持っています。その例をいくつか紹介しましょう。まず、HPC システムでは、CPU を 100% の能力で動作させることがよくあります。インテル® Xeon® スケーラブル・プロセッサーに内蔵されたアクセラレーターを最大限に活用することで、いくつかの種類のワークロードで大幅な性能向上を実現しました。例えば、AI アクセラレーターとインテル® AVX-512 は、需要の高いタスクをプロセッサーの近くに配置し、データ転送プロセス中の電力を節約します。また、データセンターのネットワーク全体の電力を監視、制御する AI ベースのテレメトリーにより、電力消費量の削減を目指します。プロセッサーには、キャッシュ、CPU 周波数、メモリー帯域、入出力 (I/O) アクセスを監視するレジスターが搭載されているため、テレメトリー機能により、大規模な省エネを実現できる可能性があります。

また、オンチップダイとオフチップの接続間のデータ転送を高速化する新しいコンセプトも導入しています。インテルの Foveros Direct は、はんだ付けによる接続を、溶融した銅同士の接続に置き換えるハイブリッド・ボンディング・アプローチです。10 ミクロンにも満たない小さな銅のバンプを融合させることで、この技術革新は、より少ないエネルギーで、より速くデータを転送することを可能にします。

上記のアプローチは、消費電力の問題を解消するものではありませんが、問題を軽減するのに役立ちます。小さな積み重ねが、より大きな効果を生むのです。

より速いイノベーションは、より環境に優しい

インテルの仕事は、ムーアの法則の上に成り立っています。しかし、ほとんどの人は、ムーアの法則が過去 50 年の間にサステナビリティーを推進したとは考えていません。今、私たちは、より少ない資源で、内蔵されたアクセラレーターからより良いパフォーマンスを得る方法を見出しています。フォトニクスのようなテクノロジーは、有線の電気接続をなくし、光によるデータ伝送に置き換える可能性を秘めています。フォトニクスは、HPC システムを高速化しながら、消費電力を劇的に削減するのに役立つ可能性があります。

ですから、業界のサステナビリティー・イニシアチブは、ムーアの法則をさらに推進し、より少ないコストでより多くのことができるようにする可能性があると考えられます。

この業界は長い道のりを歩んできましたが、持続可能なコンピューティングにおけるインテルのリーダーシップ・イニシアチブの一翼を担っていることを誇りに思います。サーバーの冷却、廃熱の回収、製造プロセスの改善、エネルギー効率に優れた製品の設計など、新しく創造的な方法を研究することで、私たちは世界中で環境にプラスの変化をもたらす可能性を持っています。