インテル® Tiber™ デベロッパー・クラウドを利用して、AI 企業は費用対効果に優れた最先端の AI アクセラレーション・プラットフォーム上で革新的なソリューションを構築、トレーニング、デプロイできます。

この記事は、インテル® デベロッパー・ゾーンに公開されている「Seekr: Building Trustworthy LLMs for Evaluating & Generating Content at Scale」の日本語参考訳です。原文は更新される可能性があります。原文と翻訳文の内容が異なる場合は原文を優先してください。

概要:

- Fast Company によって 2024年の最も革新的な企業の 1 つに選ばれた Seekr は、インテル® Tiber™ デベロッパー・クラウドを利用して、費用対効果に優れたクラスター上で高度な LLM を構築、トレーニング、デプロイしています。

- クラスターには、インテル® Gaudi® 2 AI アクセラレーターを含む、最新のインテルのハードウェアおよびソフトウェアが搭載されています。

- AI を高速化するインテルとの戦略的協業により、Seekr は増え続ける計算能力への需要に対応しつつ、クラウドコストを削減し、ワークロードのパフォーマンス向上を達成しています。

- Seekr のような急成長企業にとって、インテル® Tiber™ デベロッパー・クラウドのような最先端の AI アクセラレーション・プラットフォーム上で AI ソリューションを拡張できることは、急速なイノベーションの鍵となります。

インテル® Tiber™ デベロッパー・クラウド

クラウド、エンタープライズ、クライアント、エッジへデプロイする AI および HPC アプリケーションを構築およびテストするため、最新のインテルのハードウェアおよびソフトウェアにアクセスできるクラウド開発環境です。

https://www.xlsoft.com/jp/products/intel/devcloud/services.html

Seekr

seekr.com (英語)

デジタルコンテンツはマーケティング戦略と広告収入を促進するが、ブランドの安全性と適合性の確保が困難

信頼できるブランドを構築するには、思慮深いコンテンツ戦略が必要です。コンテンツ制作とメディアの連携は、ブランドにとって安全で、ターゲット・オーディエンスに適したものでなければなりません。しかし、膨大な量のデジタルコンテンツと多種多様なチャネルがあるため、企業が配信するコンテンツが一貫してブランドの基準を満たしていることを確認するのはほぼ不可能です。

Seekr は、ブランドが最適なオンラインコンテンツを見つけ、責任を持ってリーチを拡大できるよう、独自の採点と分析技術を活用する SeekrAlign により、広告業界のこの課題の解決を支援しています。

インテル® Tiber™ デベロッパー・クラウドの 8 ノードのインテル® Gaudi® 2 AI アクセラレーター (英語) クラスター上で構築、トレーニング、デプロイされた Seekr の最初の AI ソリューションは、瞬く間にさまざまな業界の大手ブランドで構成される素晴らしい顧客リストを獲得しました。Moderna、SimpliSafe から Babbel に至るまで、企業は課題解決に AI ソリューションを使用する価値を実感しています。インテル® Tiber™ デベロッパー・クラウドの AI アクセラレーション・プラットフォームはこの動向の最前線にあり、企業が最新のインテルのハードウェアとソフトウェアを搭載した費用対効果に優れたクラスターを使用して、AI 戦略を加速および拡張できるようにします。

AI の課題と可能性

誤った情報、ハルシネーション、不適切なコンテンツは、ブランドの信頼を急速に損なう可能性があります。リスクのあるコンテンツをホストしているプラットフォームと不用意に関わることさえ、ブランドの評判を危険にさらす可能性があります。このため、多くの企業は配信するコンテンツを厳密に審査していますが、そのプロセスは、時間とコストがかかり、信頼性が低く、非常に主観的です。

主な使用例としてポッドキャストが挙げられます。ポッドキャストの人気は近年急激に高まっており、多くの企業にとってコンテンツ戦略と広告収入の重要な部分となっていますが、残念なことに、これまでは人間が個々のエピソードを評価する以外に信頼できる方法がなかったため、ブランドにとって特に対応が困難でした。

SeekrAlign は、企業が数十万ものポッドキャストを迅速かつ正確にスクリーニングできるようにすることで、この課題を解決します。ポッドキャスト広告代理店 Oxford Road の Dan Granger 最高経営責任者 (CEO) は次のように述べています。

「SeekrAlign は、世界クラスのエンジニアリングと革新的かつ透明性の高い評価を組み合わせることで、安全で適切なポッドキャストの検索を簡素化します。これにより、ブランドはニュアンスに応じてナビゲートできるようになり、オーディオ・キャンペーンをより明瞭かつ迅速に自信を持って成長させることができます。」1

SeekrAlign のユーザーフレンドリーなダッシュボードは、ポッドキャスト・コンテンツを 0~100 の範囲で採点します。GARM (Global Alliance for Responsible Media) の安全性フレームワークに基づいた、Seekr Civility Score* と呼ばれるこの特許取得済みの採点システムは、マーケティング担当者や広告主にコンテンツの安全性と適合性を判断する客観的な基準を提供します。Seekr の Rob Clark 社長兼最高技術責任者 (CTO) は、次のように語っています。

「このような大規模な課題は、優れた計算能力と斬新な信号検出を組み合わせることでしか解決できませんでした。Civility Score* は、多数の考慮事項を 1 つの指標に統合し、よりブランドに適した可能性と、より多くのオーディエンスへの扉を開きます。」2

SeekrAlign プラットフォームはすでに 2,000 万分のポッドキャストを採点しており、その数は 2024年末までに最大 4,000 万分に達すると予測されています。さらに、このプラットフォームは 8,000 以上のポッドキャスト・エピソード、合計 1,000 万分以上の音声をリアルタイムで採点しています。Clark 社長兼 CTO は次のように述べています。

「AI が責任と透明性を持って適用されれば、この技術は発展し進歩し続ける中で、実際のビジネス課題を解決できることを示しています。最も厄介な社会問題を解決し、驚異的なスピードと精度でビジネスの成長を促進するのに役立つ先進的な LLM の開発など、継続的なイノベーションを通じてこの成功をさらに発展させることを楽しみにしています。」3

クラウド・コンピューティング・コストを削減し、ハイパフォーマンスを実現

Seekr の高度な AI ワークロード要件は、膨大な計算能力を必要とします。これまで、この計算能力には、多大なインフラストラクチャー投資とクラウドコストを要しましたが、インテル® Tiber™ デベロッパー・クラウドを利用すれば、数分の 1 の費用で最先端のインテルのハードウェアとソフトウェアにアクセスできます。Seekr のような急成長企業にとって、最新の AI アクセラレーション・テクノロジーにアクセスしながら、資本を抑え収益を拡大できることは、非常に魅力的な提案です。

Clark 社長兼 CTO は次のように語っています。

「インテルとの戦略的協業により、高帯域幅の相互接続に支えられた最新のインテル® Gaudi® チップを 1,000 個搭載したスーパーコンピューターを使用して、最適な価格と最高のパフォーマンスで基盤モデルを構築できます。当社の信頼できる AI 製品と「AI ファースト」のインテル® Tiber™ デベロッパー・クラウドの組み合わせは、エラーやバイアスを低減するため、あらゆる規模の組織が信頼できる LLM と基盤モデルにアクセスして、信頼できるハードウェア上で実行し、生産性を高め、イノベーションを促進できます。」

インテルとの戦略的協業により、Seekr は最新のインテル® Gaudi® チップを 1,000 個搭載したスーパーコンピューターを用いて、最適な価格と最高のパフォーマンスで基礎モデルを構築できるようになりました…

信頼できる結果をもたらす柔軟な AI ソリューション

SeekrFlow は、スケーラブルで構成可能なパイプラインを使用して原則に沿った LLM を構築することに重点を置いたエンドツーエンドの LLM 開発ツールセットであり、この革新的なソリューションの基盤です。SeekrFlow は最大の効率と柔軟性を実現するように設計されており、開発者はスケーラブルで構成可能なワークフローを使用して LLM をトレーニングおよび構築できます。LLM パイプライン全体は API で管理され、カスタム・コンポーネントで適応させることができます。リソースや依存関係などの計算グラフの仕様は柔軟であり、さまざまな設定オプションを利用可能です。

SeekrFlow のワークフローは、バージョン管理された、反復および再現可能な実行ファイルにコンパイルされます。また、LLM の動作が所定の標準、意図、ルール、または値に準拠していることを保証するため、堅牢なアライメント・アルゴリズムが統合されています。これらの LLM はまた、強力な推論パイプラインの恩恵を受けており、プラットフォームは大規模な音声の文字起こし、ダイアライズ、採点を行うことができます。最適化されたカスタム LLM は、ユーザーフレンドリーな SeekrAlign プラットフォームに送られ、デジタルコンテンツの迅速かつ正確な評価に使用されます。

インテル® Tiber™ デベロッパー・クラウドでの Seekr のデプロイ

Seekr は、GPU および CPU 対応システムのサーバーフリートをホストするため、地域のコロケーション・プロバイダーを使用していました。自己管理型のコンピューティング・インフラストラクチャーは、LLM およびマルチモーダル・モデルの開発に使用され、SeekrAlign をサポートしています。

顧客の増加と LLM の規模拡大に伴い、Seekr は優れた価格とパフォーマンスにより、ビジネスの拡大を支援してくれるクラウド・サービス・プロバイダーを探していました。インテル® Gaudi® 2 上で LLM のベンチマークのチューニングと推論に成功した Seekr は、LLM の開発と運用導入をサポートするコンピューティング・インフラストラクチャーとしてインテル® Tiber™ デベロッパー・クラウドの採用を決定しました。

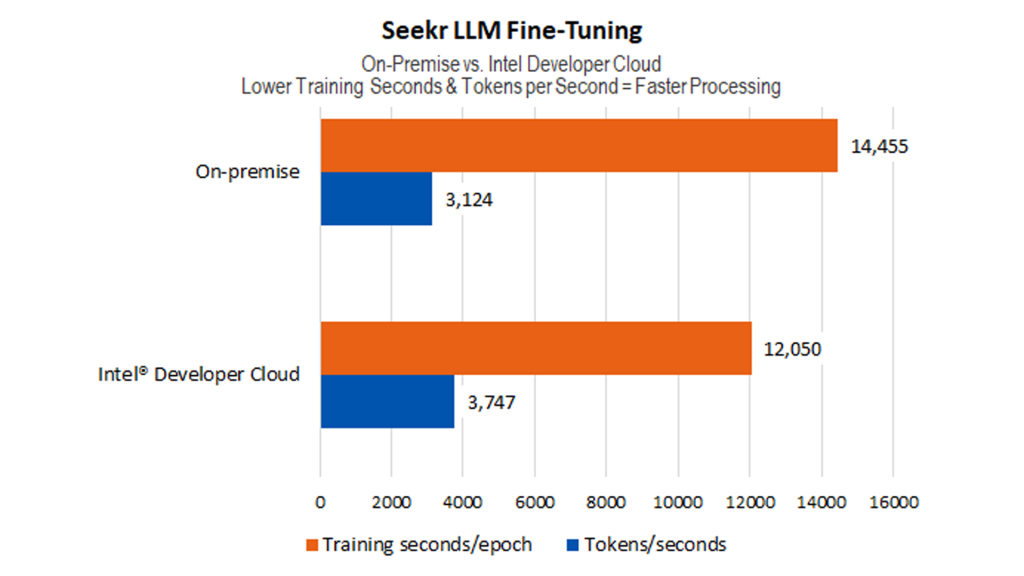

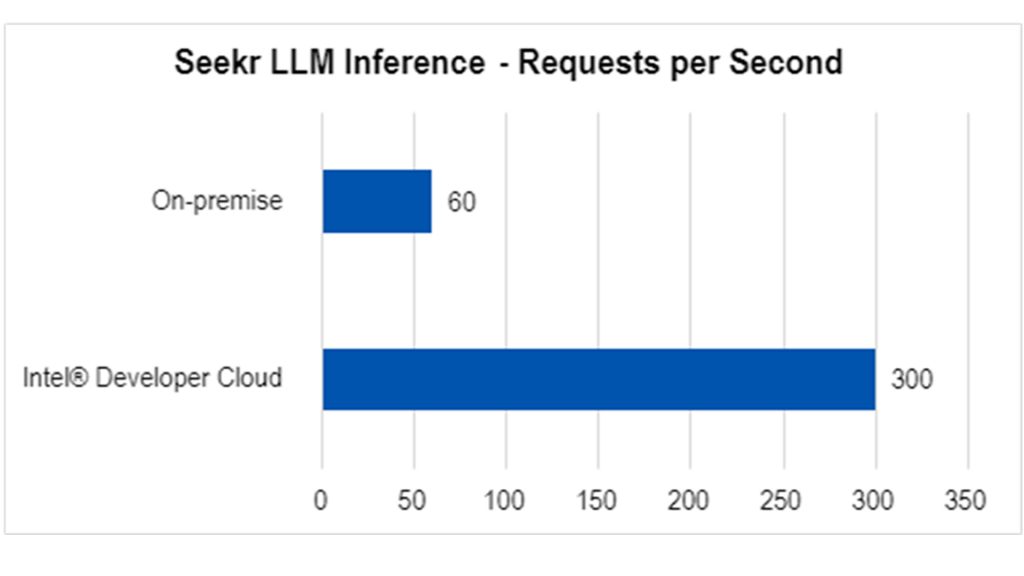

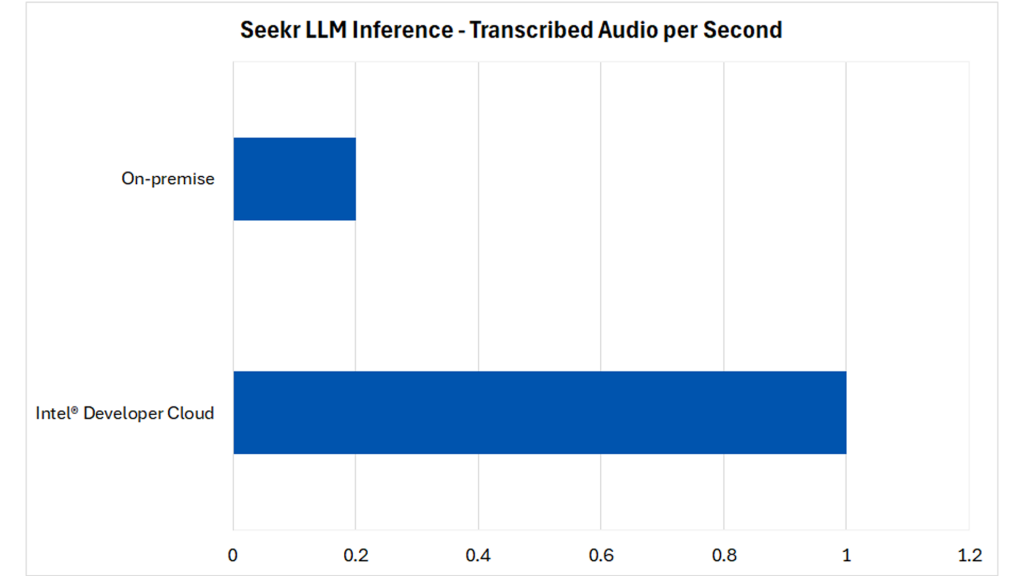

図 1~3 は、ソフトウェアの最適化とインテル® Tiber™ デベロッパー・クラウド環境の使用によって得られるパフォーマンスを示しています。

出典: Seekr。インテルは、サードパーティーのデータについて管理や監査を行っていません。ほかの情報も参考にして、正確かどうかを評価してください。

出典: Seekr。インテルは、サードパーティーのデータについて管理や監査を行っていません。ほかの情報も参考にして、正確かどうかを評価してください。

出典: Seekr。インテルは、サードパーティーのデータについて管理や監査を行っていません。ほかの情報も参考にして、正確かどうかを評価してください。

Seekr は、ソリューション・プラットフォームをインテル® Tiber™ デベロッパー・クラウドに移行するため、段階的なデプロイを計画しています。クラウド内の AI に最適化されたさまざまな計算インスタンスを使用して、アプリケーション・ワークロードの導入コストとパフォーマンスを最適化しています。

- インテル® Gaudi® 2 アクセラレーター: SeekrAlign ソリューションを支える 7B LLM モデルは、インテル® Gaudi® 2 システムのクラスター上にデプロイされ、機密コンテンツの分類とリスク評価を実行します。

- インテル® データセンター GPU マックス 1550: Seekr は、PyTorch* 向けインテル® エクステンションを使用して、インテル® GPU 搭載システムのクラスター上で文字起こしとダイアライズの処理を行っています。

- インテル® Xeon® スケーラブル・プロセッサー: 第 4 世代インテル® Xeon® CPU 搭載システムのクラスターを、アプリケーション・モニタリング、ストレージ管理、ベクトルおよび転置インデックス・データベース・サービスに使用しています。これらは、Seekr の Retrieval Augmented Generation サービスや、スケーラブルで構成可能なパイプラインを使用して原理に合わせた LLM を構築する SeekrFlow をサポートしています。

- 2024年後半には、第 5 世代インテル® Xeon® スケーラブル・プロセッサーを利用する予定です。

Seekr の AI 研究開発責任者である Stefanos Poulis 氏は次のように述べています。

「Seekr とインテルの協業は、ハイブリッド・コンピューティングでの AI の実行の可能性を解き放ちます。大規模および中規模のトランスフォーマーをトレーニングして提供するため、インテル® GPU とインテル® Gaudi® 2 チップを利用したところ、モデルのトレーニングと推論のパフォーマンスにおいて、市場の他のチップと比較して向上が見られ、特に LLM 推論では、インテルの HPU および GPU の大容量メモリーにより、バッチサイズなどのワークロード固有のパラメーターを調整できるようになりました。ソフトウェア面では、インテルのさまざまな拡張機能により、ML スタックをインテルのハードウェアにシームレスに移行できました。」

インテル® Tiber™ デベロッパー・クラウドへの統合フェーズの一環として、Seekr は、インテルの Kubernetes サービスと大規模なインテル® Gaudi® 2 クラスターを活用して LLM 基盤モデルをトレーニングし、CPU と GPU の計算能力を強化して、信頼性の高い AI サービスの提供を拡大する予定です。

SimpliSafe* は Seekr の LLM ソリューション「SeekrAlign」を利用して、より広範なカスタマイズされたホーム・セキュリティーの利用者にリーチ

SimpliSafe* (英語) は、顧客に最新かつ最高のテクノロジーを提供することで「すべての家庭を安全にする」ことを使命とする、受賞歴のあるホーム・セキュリティー・ソリューションです。同社は、進化し続けるスマートホーム業界の先駆者であることに大きな誇りを持っており、市場リーチを思慮深く効率的に拡大する新しいマーケティング・テクノロジーのテストなど、同社がサポートするビジネス機能にもその思いが受け継がれています。さらに、顧客の信頼を築き、維持することは、SimpliSafe* の顧客拡大戦略にとって極めて重要です。同社は、革新的な製品やサービスだけでなく、思慮深い広告を通じてこれを実現しています。

SimpliSafe* は SeekrAlign を利用して、適切なコンテンツチャネルを通じて、適切なタイミングで潜在顧客にリーチしています。SeekrAlign を使用することで、SimpliSafe* は数千ものポッドキャストのコンテンツスコアにリアルタイムでアクセスでき、会話レベルでコンテキストを分離できます。Seekr の LLM ベースのコンテンツ分析能力は、現在市販されているものを凌駕しており、SimpliSafe* がブランドに適したコンテンツを発見して、関連するオーディエンスにリーチするのに役立っています。

「信頼と安全が原動力のブランドとして、SimpliSafe* の価値観を共有できるソリューションを見つけることが重要でした。インテル® Tiber™ デベロッパー・クラウドを利用した Seekr は、まさにそのようなプラットフォームであり、ポッドキャストの監視という大規模な問題を慎重に解決し、広告掲載先が当社の顧客プロファイルと一致することを確実にしてくれます。Seekr のおかげで、ブランドにとって安全なポッドキャストを見つけ、それを通じて適切なオーディエンスにリーチし、最終的に SimpliSafe* のホーム・セキュリティー・ソリューションをより多くの住宅所有者に紹介することができます。」

SimpliSafe 顧客獲得担当ディレクター Nicholas Giorgio 氏

関連情報

- Seekr (英語)

- インテル® Tiber™ デベロッパー・クラウド

- インテル® Liftoff

- インテル® Gaudi® 2 AI アクセラレーター – habana.ai (英語)

- インテルのエンタープライズ・ソフトウェア・ソリューション

スタートアップ向けのインテル® Liftoff プログラム

インテル® Liftoff は、初期段階の AI やマシンラーニングなどのスタートアップ企業向けの無料の仮想プログラムです。インテルが 2022年に開始したこのプログラムは、スタートアップ企業がコードの障壁を取り除き、パフォーマンスを発揮し、アイデアをスケーラブルで業界を定義する AI 企業に変えることができるように支援します。

製品および性能に関する情報

1www.prnewswire.com/news-releases/seekr-introduces-align-brand-safety-and-suitability-platform-to-drive-doubling-of-podcast-industry-beyond-4-billion-in-24-months-302042420.html

2www.prnewswire.com/news-releases/seekr-civility-score-awarded-patent-for-automatic-scoring-and-analysis-of-audio-content-302060869.html

3www.prnewswire.com/news-releases/rob-clark-named-president-and-chief-technology-officer-of-seekr-301882009.html

4性能は、使用状況、構成、その他の要因によって異なります。詳細については、http://www.intel.com/PerformanceIndex/ (英語) を参照してください。