Docker Model Runner が一般提供 (GA) となりました。

2025 年 4 月に Beta 版として登場した Docker Model Runner は、ローカルの AI モデル (特に LLM) を簡単に管理、実行、配布できるようにするための製品です。それからわずか数か月で、継続的な改善を重ね、信頼性と安定性の面で十分に成熟したレベルに到達しました。

本記事では、Docker Model Runner が開発者にもたらす主要な機能を振り返るとともに、今後の展望についてもご紹介します。

Docker Model Runner とは

Docker Model Runner (DMR) は、開発者が使いやすいように設計されており、Docker Hub (OCI 準拠フォーマット) や HuggingFace (GGUF フォーマットの場合は HuggingFace 側で自動的に OCI アーティファクトとしてパッケージ化) から、大規模言語モデル (LLM) を直接プル、実行、配布できます。

Docker Desktop や Docker Engine と緊密に統合されており、OpenAI 互換 API を通じたモデルの提供、GGUF ファイルを OCI アーティファクトとしてパッケージ化、CLI/GUI/開発者向け REST API を介した操作が可能です。

生成 AI アプリケーションの開発、機械学習ワークフローの実験、あるいはソフトウェア開発ライフサイクルへの AI 組み込みなど、幅広い用途で Docker Model Runner はローカルにおける一貫性、セキュリティ、効率性の高い環境を提供します。

詳細については公式ドキュメントをご参照ください。

なぜ Docker Model Runner なのか

Docker Model Runner を使えば、開発者は日常的に利用している Docker コマンドやワークフローの延長で、AI アプリケーションやエージェント型アプリケーションを簡単に試作、構築できます。新しいツールを学ぶ必要はありません。

多くの新しい AI ツールとは異なり、複雑さを持ち込んだり、導入に特別な承認を必要としたりすることはありません。既存のエンタープライズ環境にそのまま適合し、現在のセキュリティ、コンプライアンス体制の範囲内で動作するため、チームは安心して導入できます。

さらに、Model Runner は OCI 形式でパッケージ化されたモデルをサポートしており、Docker Hub をはじめ、あらゆる OCI 互換レジストリを通じて保存、配布が可能です。Docker Hub を利用するチームは、Registry Access Management (RAM) などのエンタープライズ機能により、ポリシーベースのアクセス制御を活用し、大規模な環境でもセキュリティを確保できます。

開発者に特に評価されている Docker Model Runner の 11 の機能

- llama.cpp ベース

現在、DMR は llama.cpp を基盤として構築されています。今後もサポートを継続するとともに、将来的には MLX や vLLM など、他の推論エンジンへの対応も検討しています。 - macOS/Windows での GPU アクセラレーション

ハードウェアの性能を最大限に活用可能。macOS では Apple Silicon、Windows では NVIDIA GPU、さらに ARM/Qualcomm アクセラレーションにも対応し、すべて Docker Desktop 経由でシームレスに管理できます。 - Linux ネイティブ対応

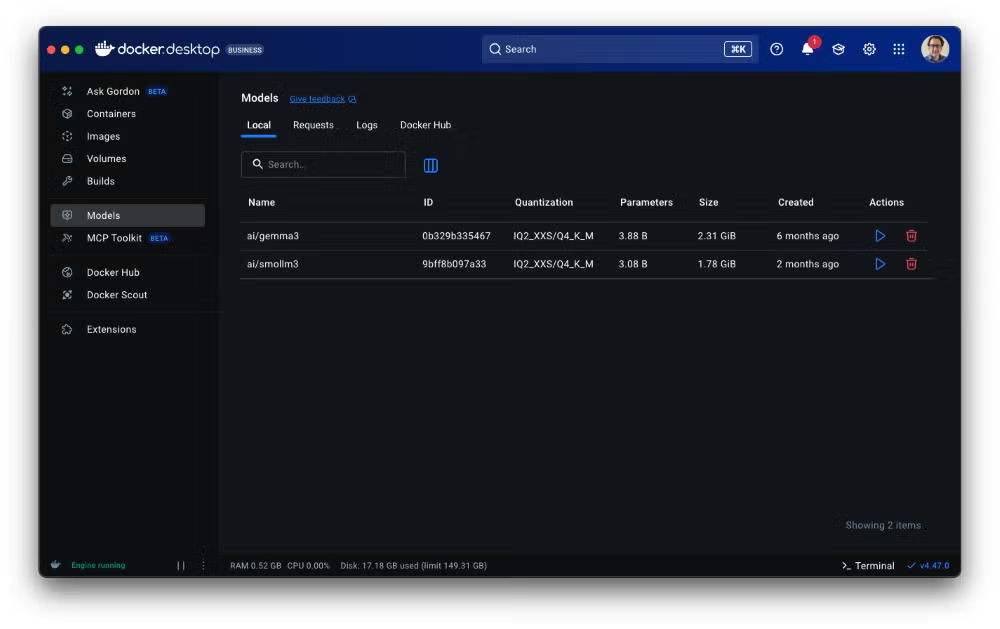

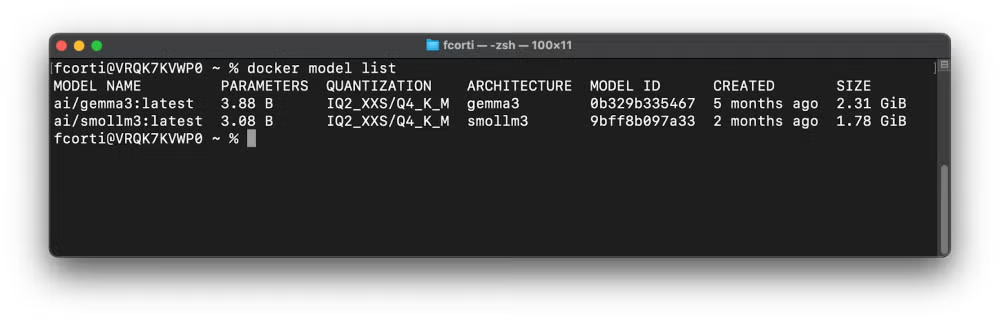

Docker CE 上で Linux でも DMR を実行可能。自動化、CI/CD パイプライン、プロダクション環境に最適です。 - CLI と UI の両方に対応

Docker CLI (Docker Desktop/Docker CE 双方) から利用できるだけでなく、Docker Desktop の UI からも操作可能。UI では初めて AI を扱う開発者でもスムーズにモデルを提供開始できるよう、リソース (RAM/GPU など) の自動管理を含むガイド付きオンボーディングが用意されています。

- 柔軟なモデル配布

Docker Hub から OCI フォーマットでモデルをプル/プッシュできるほか、HuggingFace リポジトリにある GGUF フォーマットのモデルを直接プルすることも可能です。これにより、モデルの取得や共有の柔軟性が大きく向上します。 - オープンソースかつ無料

DMR は完全にオープンソースで、誰でも無料で利用できます。AI を試したり構築したりする開発者にとって、参入障壁を大きく下げる存在です。 - 安全で制御可能

DMR はメインのシステムやユーザーデータに干渉しない隔離された環境 (サンドボックス) で実行されます。開発者や IT 管理者は、DMR の有効化/無効化や、ホスト側 TCP サポート、CORS などの設定を調整することで、セキュリティや利用範囲を細かくコントロールできます。 - 推論設定のカスタマイズ

利用シーンに合わせてコンテキスト長や llama.cpp の実行フラグをカスタマイズ可能です。今後さらに多くの設定オプションが追加される予定です。 - デバッグ機能

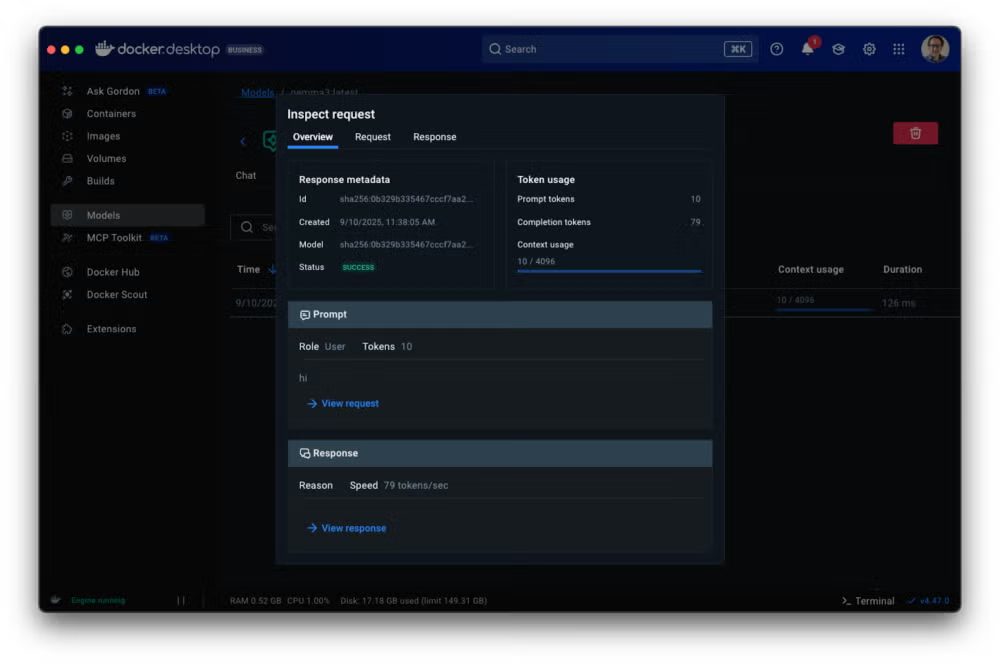

リクエスト/レスポンスのトレースやインスペクト機能を備えており、トークンの使用状況やフレームワーク/ライブラリの挙動を可視化できます。これにより、開発者はアプリケーションのデバッグや最適化を容易に行えます。

- Docker エコシステムとの統合

DMR は Docker Compose とそのまま連携できるほか、Docker Offload (クラウド オフロード サービス) や Testcontainers など、他の Docker 製品とも完全に統合されています。これにより、ローカル環境から分散ワークフローまで、幅広いシナリオで活用できます。 - 最新のモデル カタログ

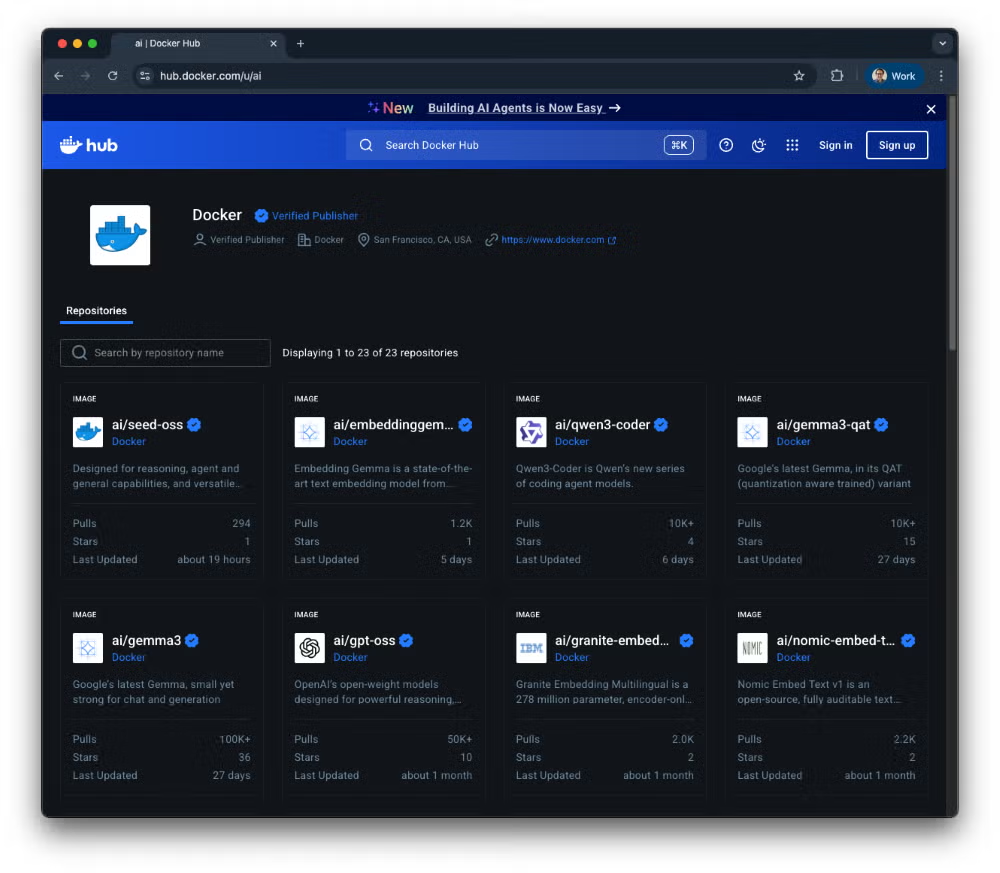

Docker Hub には、人気が高く強力な AI モデルを厳選したカタログが用意されています。これらのモデルは無料でプルでき、開発環境からパイプライン、ステージング、さらには本番環境まで幅広く利用可能です。

今後の展望

Docker Model Runner に関するリリース予定の強化点を、以下にご紹介します。

より洗練されたユーザー体験

DMR を開発者にとって直感的かつ使いやすいものにすることを目指しています。具体的には、Docker Desktop や CLI 内でのチャット風インターフェースにおける応答表示の強化、UI でのマルチモーダル対応 (API ではすでに利用可能)、MCP ツールとの統合、さらにデバッグ機能や設定オプションの拡充による柔軟性の向上などです。最後に、AI エコシステム全体に広がるサードパーティ ツールやソリューションとの統合も、よりスムーズかつシームレスに実現していく予定です。

実行性能と柔軟性の向上

ローカル モデルの実行において、DMR のパフォーマンスと柔軟性を継続的に改善していきます。今後は、広く利用されている推論ライブラリやエンジンへの対応、エンジン/モデル単位での高度な設定オプション、さらに Docker Engine から独立して Model Runner をデプロイできる機能 (プロダクション用途向け) などを予定しています。その他にも数多くの改善を計画中です。

スムーズなオンボーディング

初めて AI を扱う開発者でもすぐにアプリケーションを構築できるよう、オンボーディング体験をさらに改善します。ガイド付きのステップバイステップ体験を提供し、サンプル アプリケーションとセットで活用できるようにする予定です。これらのサンプルは、実際のユースケースやベストプラクティスを示し、日常的なワークフローで DMR を試し、導入するためのスムーズな入り口となります。

モデル提供の最新性を確保

推論機能を強化する中でも、Docker Hub を OCI アーティファクト (モデルを含む) の主要レジストリとして、常に一流の AI モデル カタログを維持することに注力していきます。新しい関連モデルが公開された際には、Docker Hub にすぐ追加され、DMR で実行可能になることを目指しています。

まとめ

Docker Model Runner は短期間で大きく進化し、Beta 版から成熟した安定的な推論エンジンへと成長し、今回ついに一般提供に至りました。

DMR が目指しているのは、開発者が普段通りの Docker CLI コマンドやツールを使うだけで、AI モデルをローカル環境で簡単、安全、一貫して利用できるようにすることです。

今こそ始める絶好のタイミングです。まだの方は Docker Desktop をインストールし、ぜひ Docker Model Runner をお試しください。公式ドキュメントを参照してその機能を確認し、DMR が AI アプリケーション開発の加速にどのように役立つのかをご体感ください。

エクセルソフトは Docker の Preferred Reseller として、Docker Desktop を販売しています。Docker 製品のライセンスや機能に関するご質問、製品デモのご要望を承っています。お問い合わせはこちらから。

*本記事は、Docker 社が提供している以下の記事から抜粋・転載したものです。

Docker の最新情報をお届けするエクセルソフトのメールニュース登録はこちら。