この記事は、インテル社のウェブサイトで公開されている「Introducing Intel® Tiber™ AI Cloud」の日本語参考訳です。原文は更新される可能性があります。原文と翻訳文の内容が異なる場合は原文を優先してください。

エキサイティングな新発表があります。インテルの急成長中のクラウドサービスは、新たにインテル® Tiber™ AI クラウドと呼ばれるようになりました。これは、インテル® Tiber™ クラウドサービスの一部であり、AI の導入、開発者エコシステムのサポート、ベンチマーク・テスト向けに、インテルのコンピューティングとソフトウェアへの大規模なアクセスを提供します。

インテル® Tiber™ デベロッパー・クラウドを基盤として構築されたインテル® Tiber™ AI クラウドは、開発者やオープンソース・パートナーのユーザー・コミュニティーが拡大する一方で、より多くの有償顧客や AI パートナーの間でプロダクション規模の AI 導入に対する重要性が高まっていることを反映しています。

新しい機能強化

最近、インテル Tiber™ AI クラウドでは、以下の機能が強化されました。

- 新しいコンピューティング・オプション: 2024年9月のインテル® Gaudi® 3 AI アクセラレーターの発表と同時に、インテル® Tiber™ AI クラウド上でインテルの最新 AI アクセラレーター・プラットフォームの構築を開始し、年内には一般提供できる予定です。さらに、128 コアの新しいインテル® Xeon® 6 CPU を搭載したコンピューティング・インスタンスと、新しいインテル® Core™ Ultra プロセッサーを搭載した AI PC 向けのプレリリースの開発キットが、インテル® Tiber™ AI クラウドの Preview カタログから技術評価に利用できるようになりました。

- オープンソース・モデルとフレームワークの統合: インテルは、PyTorch* 2.4 リリースでインテル® GPU のサポートを発表しました。Learning カタログ※のノートブックで、インテルがサポートする最新の Pytorch* リリースを評価できます。

- Meta の Llama* モード・コレクションの最新バージョン Llama* 3.2 は、インテル® Gaudi® AI アクセラレーター、インテル® Xeon® プロセッサー、およびインテル® Core™ Ultra プロセッサーを搭載した AI PC での検証が終わり (英語)、インテル® Tiber™ AI クラウドへの導入準備が整いました。

- 拡張された学習リソース: Learning カタログ※に追加された新しいノートブックを介してインテル® Gaudi® AI アクセラレーターにアクセスできます。AI 開発者とデータ・サイエンティストは、これらのノートブックを使用してインテル® Gaudi® AI アクセラレーター上で対話型シェルコマンドを実行できます。さらに、インテルのクラウドチームは DeepLearning.ai および Prediction Guard と協力して、インテル® Gaudi® AI アクセラレーターを搭載したコンピューティング・インスタンスでサポートされる新しい LLM コース (英語) を提供しています。

- パートナーシップ: インテルは Intel Vision 2024 カンファレンスにおいて、急成長中の AI 企業 Seekr とのパートナーシップを発表しました。Seekr は現在、インテルの AI クラウド上の 1,024 を超えるインテル® Gaudi® AI アクセラレーターで構成された新しいスーパーコンピューター・クラスターの 1 つを使用して、企業が AI アプリケーションにおける不正確さやバイアスの課題を克服するのに役立つ基礎モデルと LLM をトレーニングしています。信頼性の高い AI プラットフォームである SeekrFlow (英語) は現在、インテル® Tiber™ AI クラウドの Software Catalog から利用可能です。

※ Learning カタログのノートブック (Jupyter* notebook 経由のトレーニング) へアクセスいただくには、クーポンコードを事前にご登録いただく必要があります。エクセルソフトでは、インテル® Tiber™ AI クラウドを評価いただくためのクーポンを配布しています。ご興味のある方は、こちらのフォームよりお問い合わせください。

仕組み

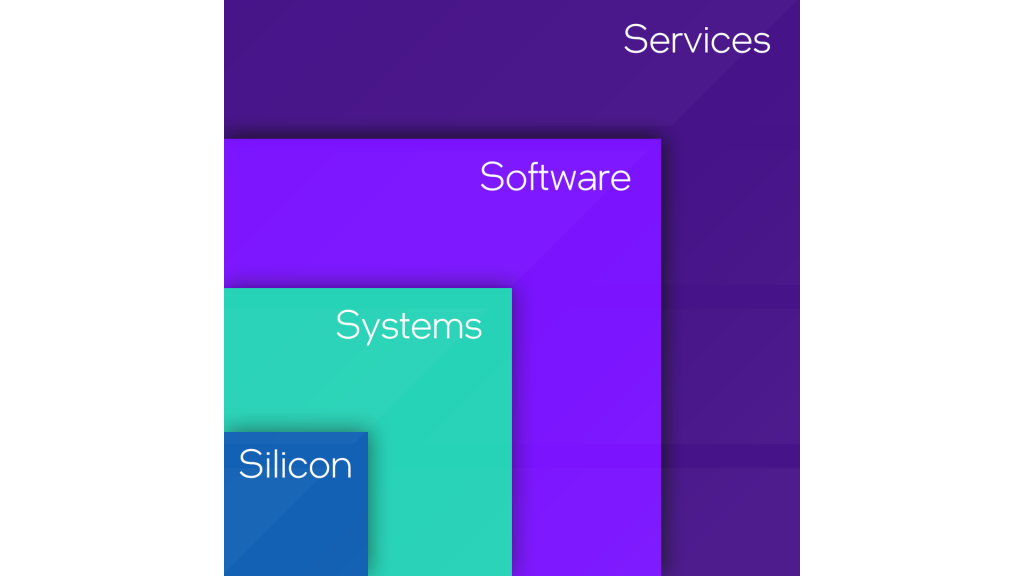

インテルが提供する AI クラウドの主な構成要素であるシリコン、システム、ソフトウェア、サービスについて説明します。

シリコン:

- インテル® Tiber™ AI クラウドでは、インテルの最先端の CPU、GPU、AI アクセラレーターを「最初の顧客」としていち早く利用し、インテルのエンジニアリング・チームから直接サポートを受けることができます。

- プレリリースを含む、最新のインテルのハードウェアとソフトウェアへの早期アクセスを低コストで実現します。

システム:

- AI ワークロードの規模とパフォーマンス要件の増加に伴い、コンピューティング・インフラストラクチャーへの要求は急速に進化しています。

- インテル® Tiber™ AI クラウドは、コンテナ、仮想マシン、専用システムなど、さまざまなコンピューティング・オプションを提供し、AI ワークロードを展開できるようにします。さらに、最近、基盤モデルのトレーニング用に高速イーサネット・ネットワークを備えた、小規模からスーパーコンピューティング規模までのインテル® Gaudi® AI アクセラレーター・ベースのクラスターを導入しました。

ソフトウェア:

- インテルは、成長を続ける AI 向けオープン・ソフトウェア・エコシステムをサポートし、Pytorch* や UXL Foundation などのオープンソース・プロジェクトに積極的に貢献しています。

- オープンソース・プロジェクトをサポートするため、専用のインテルのクラウド・コンピューティングが割り当てられており、ユーザーはインテル® Tiber™ AI クラウドで最新の AI フレームワークとモデルにアクセスできます。

サービス:

- 企業ユーザーと開発者は、技術的な専門知識、実装要件、ユースケースに応じて、コンピューティング AI サービスを異なる方法で利用します。

- 多様なアクセス要件を満たすため、インテル® Tiber™ AI クラウドは、サーバー CLI アクセス、ノートブックを使用した対話型アクセス、サーバーレス API アクセスを提供します。

インテル® Tiber™ AI クラウドの重要性

インテル® Tiber™ AI クラウドは、スタートアップ、エンタープライズ顧客、開発者の AI 採用の障壁を取り除き、競争力を向上させるインテル戦略の重要な要素です。

- コスト・パフォーマンス: 最適な AI 導入を実現するため、インテルが提供する最新のコンピューティングへの早期アクセスを魅力的なコスト・パフォーマンスで提供します。

- スケーラビリティー: 仮想マシン (VM) や単一ノードから大規模なインテル® Gaudi® 3 AI アクセラレーターを搭載したスーパーコンピューティング・クラスターまで、AI 導入の拡大に応じてスケールアウトできるコンピューティング・プラットフォームを提供します。

- オープンソース: インテルがサポートするオープンソース・フレームワーク、モデル、アクセラレーター・ソフトウェアにアクセスできるため、移植性が確保され、ベンダー依存を回避できます。

次のステップ

今後数か月間で、インテル® Gaudi® 3 AI アクセラレーターとインテル® Xeon® 6 プロセッサーの処理能力をさらに増強し、AI 導入のフットプリントを拡大するため新しいリージョンを追加していきます。

製品および性能に関する情報

1 性能は、使用状況、構成、その他の要因によって異なります。詳細については、http://www.intel.com/PerformanceIndex/ (英語) を参照してください。

25年以上にわたる販売実績を誇るエクセルソフトのサポートサービス

エクセルソフトは、国内で HPC クラスターシステムやデータセンターの運用に携わる大学機関、政府機関、民間企業を中心とする組織向けにツールの導入やプログラムの最適化に携わってきた経験を活かし、国内のエンジニアや企業の開発を日本語でサポートしています。

インテルの最新のハードウェアを搭載したクラウドサービス「インテル® Tiber™ AI クラウド」の導入サポートも追加し、LLM や生成 AI を活用する AI アプリケーションやサービスの開発および運用を支援します。AI スタートアップ企業の育成に特化したインテルの無料プログラムの推薦なども行っています。